GoogleがAIに無限の長さのテキストを処理できる能力を与える技術を発表

Googleの研究者が、大規模言語モデル(LLM)に無限の長さのテキストを処理させる手法だという「Infini-attention」に関する論文を発表しました。

[2404.07143] Leave No Context Behind: Efficient Infinite Context Transformers with Infini-attention

https://arxiv.org/abs/2404.07143

Google’s new technique gives LLMs infinite context | VentureBeat

https://venturebeat.com/ai/googles-new-technique-gives-llms-infinite-context/

Google Demonstrates Method to Scale Language Model to Infinitely Long Inputs

https://analyticsindiamag.com/google-demonstrates-method-to-scale-language-model-to-infinitely-long-inputs/

AIには作業可能なトークン量を示す「コンテキストウインドウ」という枠があり、たとえばChatGPTの場合、AIとの会話量が「コンテキストウインドウ」を超過するとパフォーマンスが低下し、会話の先頭に含まれるトークンが破棄されます。

このため、処理可能なトークン量の増加は、競合に対する優位性確保とモデル改善のための主要な取り組みとなっています。

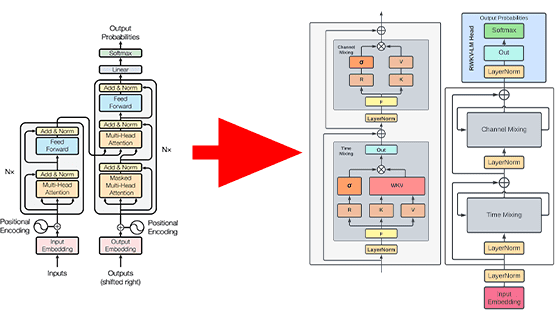

Googleの研究者が編み出した「Infini-attention」は、圧縮メモリをTransformerベースのLLMが持つメカニズムである「注意機構」に組み込み、局所注意機構と長期線形注意機構で単一のTransformerブロックを構築するというアプローチです。

取り組みのポイントは、メモリと計算量が限られた状態でも使用できる手法であるというところで、実験で長文言語モデリングベンチマークを行ったところ、Infini-attentionを使用したモデルはベースラインモデルの値を上回り、メモリサイズ基準で114倍の理解率を達成したとのこと。

最大5Kシーケンス長のパスキーインスタンスに微調整された1Bモデルでは、1M長の問題を解くことができ、理論的には、品質を維持したまま、さらに多くのトークンを同じように処理可能だそうです。

・関連記事

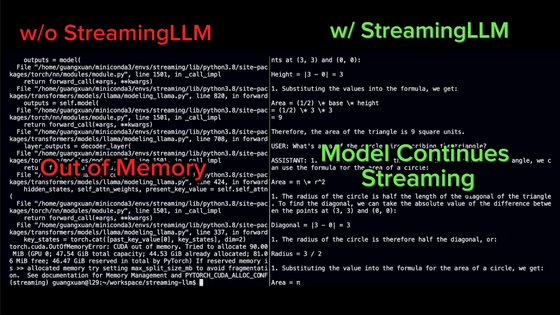

大規模言語モデルで「無限の入力」を受け付けることを可能にする手法「StreamingLLM」が開発される - GIGAZINE

言語処理のニューラルネットワークモデルが脳の働きと同じ構造をしているという仮説 - GIGAZINE

OpenAI開発のテキスト生成AI「GPT-3」がどんな処理を行っているのかを専門家が解説 - GIGAZINE

・関連コンテンツ