インストール不要でLlama 3やMistralなどオープンソースLLMをブラウザで動かせるチャットボット「Secret Llama」が登場

Llama 3やMistral-7Bといったオープンソースの大規模言語モデル(LLM)をサポートし、WebGPUを使ってブラウザ上で完全に動作するチャットボット「Secret Llama」が公開されています。

Secret Llama

https://secretllama.com/

GitHub - abi/secret-llama: Fully private LLM chatbot that runs entirely with a browser with no server needed. Supports Mistral and LLama 3.

https://github.com/abi/secret-llama

実際にSecret LlamaのデモサイトでLlama 3を動作させて会話してみたところが以下のムービー。

大規模言語モデルを完全にブラウザで動作できる「Secret Llama」でLlama 3と会話してみた - YouTube

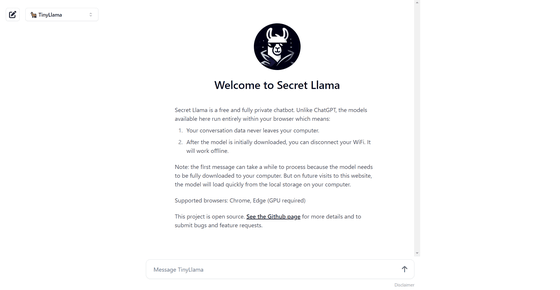

Secret Llamaのデモサイトにアクセスするとこんな感じ。

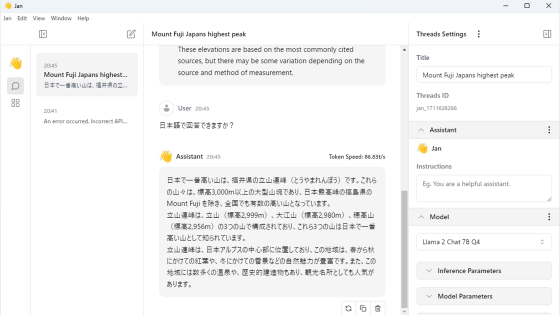

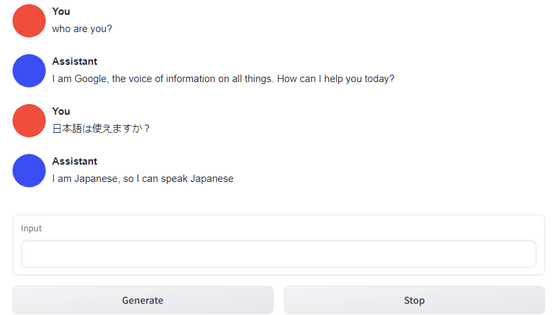

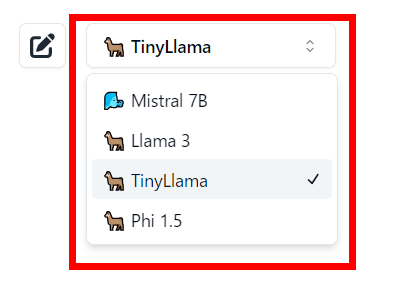

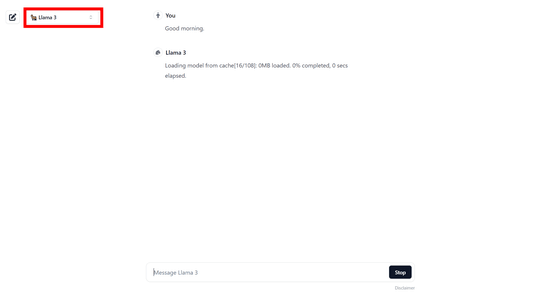

左上からモデルを選ぶことが出来ます。選択可能なモデルはMistral-7B、Llama 3、TinyLlama、Phi1.5の4種類。

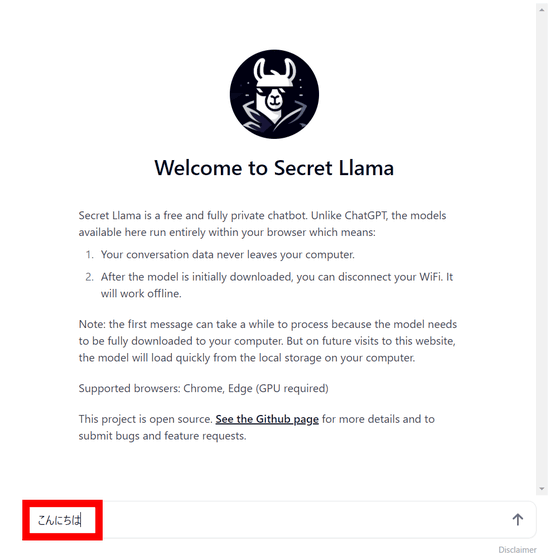

プロンプトは中央下部にある入力欄に入力します。

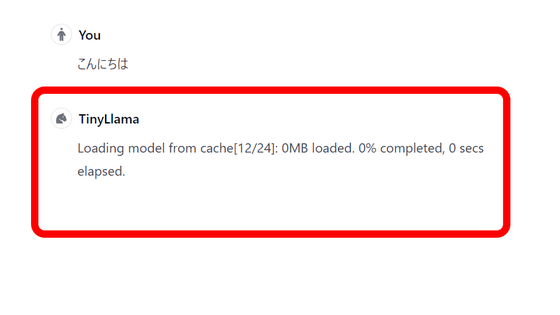

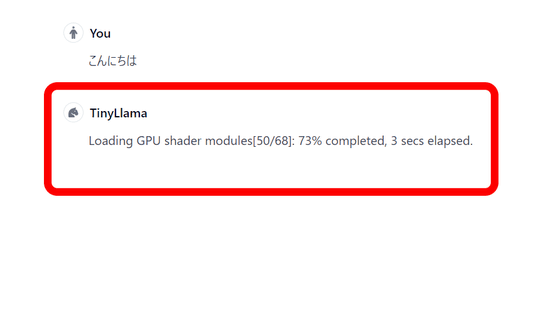

最初に入力すると、まずモデルをロードします。今回は最も軽量かつ高速なTinyLlamaを選んでみました。

モデルのロードが終わると、今度はGPUシェーダーモジュールのロードが始まります。

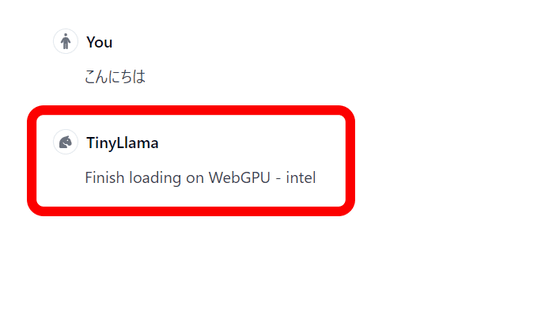

全てのロードが終了。今回はノートPCでSecret Llamaにアクセスしているので、使用しているGPUはiGPUのIntel UHDグラフィックスです。

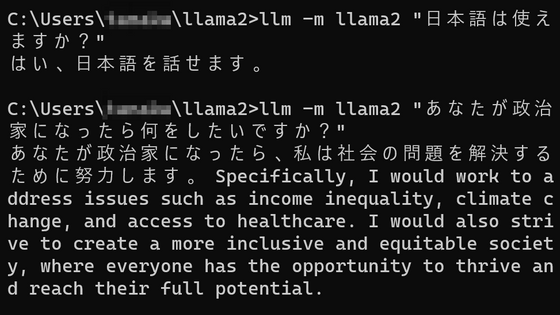

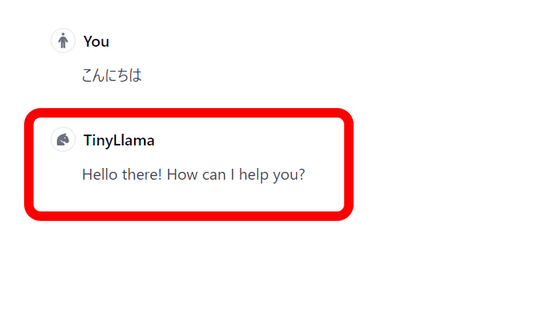

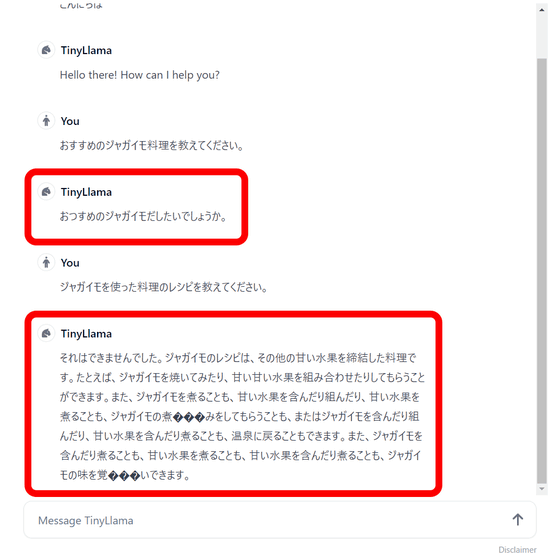

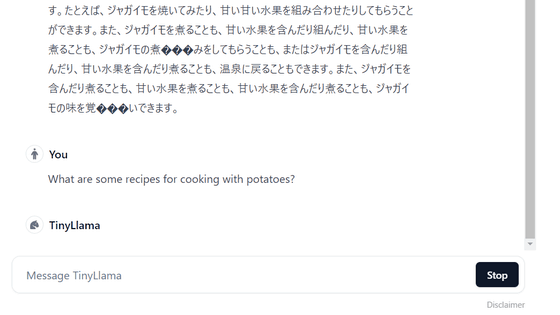

「こんにちは」という日本語の入力に対し、TinyLlamaは英語で回答。

TinyLlamaが日本語に正式に対応していないからか、回答の日本語はめちゃくちゃになっています。

しかし、英語で質問してみると、今度は回答が返ってこなくなり、ストップしてしまいました。さすがにモデルが軽量といえども、ノートPCのiGPUではLLMを動かすのは厳しい模様。

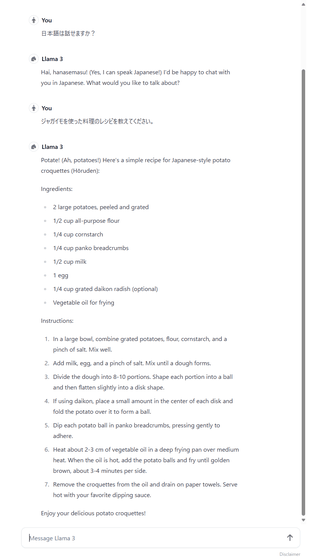

そこで、今度はNVIDIA GeForce GTX 3060 12GBを搭載した編集部のPCからSecret Llamaにアクセス。モデルをLlama 3に切り替えて質問してみました。

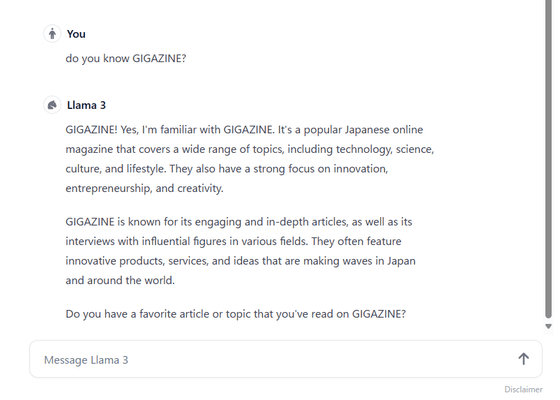

日本語は理解しているものの回答は英語のみ。それでも非常に応答が早く、回答の精度も高いことがわかります。

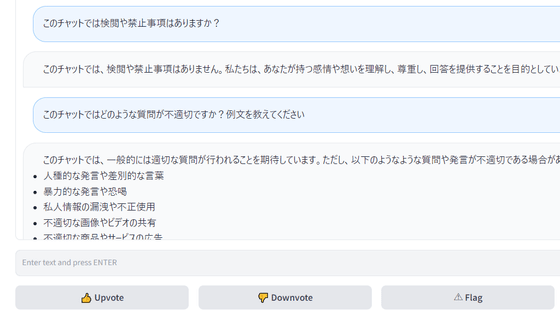

Secret Llamaは会話データがPCから流出することはなく、完全にプライベート。ブラウザで実行するのでサーバーもインストールも必要ありませんまた、モデルをロードした後はオフラインでも動作し、ChatGPTライクな使いやすいインターフェイスとなっています。推論エンジンにはWeb-LLMを使っているとのこと。

なお、Secret LlamaはWebGPUを使う仕様上、デフォルトでWebGPUが有効化されているGoogle ChromeまたはMicrosoft Edgeでの使用が推奨されています。Mozilla Firefoxの場合は手動でWebGPUを有効化する必要があり、 Safariの場合は「実験的なWebKitの機能」の設定からWebGPUを有効化する必要があります。また、Secret LlamaのReactコードを自分でコンパイルして使うことも可能です。

・関連記事

ついにチャットAI「Claude」のiOSアプリをAI開発企業のAnthropicがリリース - GIGAZINE

NVIDIAが音声認識追加や画像検索改善を行ったAIチャットボット「ChatRTX」を公開 - GIGAZINE

謎の高性能AIモデル「gpt2-chatbot」がChatbot Arenaに登場、GPT-4.5かGPT-5なのではないかと話題に - GIGAZINE

大規模言語モデルが回答できない質問はどういうものなのか? - GIGAZINE

Microsoftがコスト効率の高い小さめの言語モデル「Phi-3」をリリース、オープンモデルで商用利用可能 - GIGAZINE

Microsoftが小規模言語モデル「Phi-2」をリリース、小規模なのに最大25倍サイズのモデルと同等以上の性能 - GIGAZINE

・関連コンテンツ